آیا ChatGPT امن است؟ خطرات و اطلاعاتی که هرگز نباید به اشتراک بگذارید!

آیا ChatGPT امن است؟ خطرات و اطلاعاتی که هرگز نباید به اشتراک بگذارید!

آیا ChatGPT امن است؟ خطرات و اطلاعاتی که هرگز نباید به اشتراک بگذارید! با گسترش روزافزون استفاده از ابزارهای هوش مصنوعی مولد مانند ChatGPT، درک خطرات آن اهمیت پیدا میکند. ChatGPT تا زمانی که در مورد آنچه به اشتراک میگذارید هوشمندانه عمل کنید، ایمن است. ما خطرات امنیتی و حریم خصوصی مرتبط با ChatGPT و اینکه چگونه Norton 360 Deluxe میتواند به تقویت دفاع شما کمک کند و با ظهور تهدیدات دیجیتال جدید، ایمنتر بمانید را بررسی خواهیم کرد.

ChatGPT تا زمانی که از آن مسئولانه استفاده کنید و از به اشتراک گذاشتن اطلاعات حساس خودداری کنید، ایمن است. با این حال، مانند هر ابزار آنلاین دیگری، ضروری است که در مورد تهدیدات احتمالی حریم خصوصی و روشهای سوءاستفاده از این ابزار آگاه باشید.

در اینجا، نکات کلیدی که باید در مورد ChatGPT بدانید، از جمله خطرات امنیتی و حریم خصوصی آن، موارد سوءاستفاده و اطلاعات نادرست و نحوه استفاده مسئولانه از آن را بررسی خواهیم کرد.

چت جی پی تی چیست؟

ChatGPT نوعی هوش مصنوعی مولد (ایجاد شده توسط OpenAI) است که با تولید متن طبیعی و شبیه به انسان به درخواستهای شما پاسخ میدهد. افراد از آن برای تحقیق، تولید کد، دریافت کمک در زمینه نوشتن و دستور زبان و ایدهپردازی استفاده میکنند. این سیستم بر اساس یک مدل زبان بزرگ (LLM) ساخته شده است که بر روی حجم عظیمی از دادهها آموزش دیده است و میتواند در عرض چند ثانیه پاسخی شبیه به پاسخهای انسانی ارائه دهد.

مانند اکثر سرویسهای ابری، دادههایی که شما در ChatGPT وارد میکنید از طریق سرورها در سراسر اینترنت منتقل میشوند. دادهها در حین انتقال به سرورهای OpenAI رمزگذاری میشوند و در هیچ کجا منتشر یا فهرستبندی نمیشوند. اما، از نظر تئوری، هیچ چیز منتقل شده از طریق اینترنت ۱۰۰٪ بدون ریسک نیست، بنابراین از به اشتراک گذاشتن اطلاعات شخصی، مالی یا حساس خودداری کنید.

اگرچه خود چتبات ایمن و استفاده از آن آسان است، مجرمان سایبری میتوانند از ChatGPT برای نوشتن کدی استفاده کنند که میتواند برای اهداف مخرب مانند ایجاد سایتهای جعلی با هدف سرقت اطلاعات شما یا انتشار بدافزار در دستگاههای شما استفاده شود.

خطرات امنیتی و حریم خصوصی ChatGPT

محبوبیت ChatGPT در را به روی تهدیدات جدید امنیت سایبری، از برنامههای جعلی و کلاهبرداریهای فیشینگ گرفته تا نشت دادهها و حملات تزریق سریع، باز کرده است. اما با وجود افزایش آگاهی، خطرات نیز در حال افزایش هستند.

تا اواسط سال ۲۰۲۵، Sift از افزایش ۶۲ درصدی تعداد افرادی که با موفقیت توسط کلاهبرداریهای مبتنی بر هوش مصنوعی از سال ۲۰۲۴ مورد کلاهبرداری قرار گرفتهاند، خبر داد. با تبدیل شدن ابزارهای هوش مصنوعی به بخشی از زندگی روزمره، مهاجمان همچنان راههای هوشمندانهتری برای سوءاستفاده از آنها پیدا میکنند.

دادهها و نقضها

نقض دادهها زمانی رخ میدهد که دادههای حساس یا خصوصی بدون مجوز افشا شوند، که سپس میتواند به آنها دسترسی پیدا کرده و برای منفعت یک مجرم سایبری استفاده شود. به عنوان مثال، اگر دادههای شخصی که در مکالمه با ChatGPT به اشتراک گذاشتهاید به خطر بیفتد، میتواند شما را در معرض خطر سرقت هویت قرار دهد .

اگرچه OpenAI محتوا را با «گروه منتخبی از ارائهدهندگان خدمات مورد اعتماد» به اشتراک میگذارد ، اما ادعا میکند که دادههای کاربران را با اشخاص ثالث مانند دلالان داده که از آنها برای بازاریابی یا سایر اهداف تجاری استفاده میکنند، نمیفروشد یا به اشتراک نمیگذارد .

اما ابزارهای هوش مصنوعی هنوز هم میتوانند «تصادفا» اطلاعات حساس را فاش کنند. این مورد زمانی رخ داد که برخی از کاربران ChatGPT گزارش دادند که چتهایشان به دلیل ویژگیای که به آنها اجازه میداد چتهایشان قابل کشف باشد، در نتایج جستجوی گوگل نمایش داده میشود. این ویژگی از آن زمان حذف شده است.

شما همچنین میتوانید با کلیک برروی خرید لایسنس پرمیوم که دارای⭐️امنیت بالای فایل و پوشه ها ⭐️ تحویل لایسنس بلافاصله پس از خرید به ایمیل⭐️فایر وال, سپر شبکه و وای فای امن ⭐️ قابلیت نصب نرم افزار از سایت رسمی eset.com – آپدیت از سرور اصلی ESET تهیه و خریداری کنید.

تزریق سریع

تزریق سریع زمانی اتفاق میافتد که شخصی دستورالعملهای مخرب را پنهان میکند تا یک LLM را فریب دهد تا دستورالعملهای قبلی را نادیده بگیرد و اقدام متفاوتی انجام دهد. این معمولاً به طور غیرمستقیم، از طریق دستورالعملهای پنهان در دادههایی که از ChatGPT خواسته میشود پردازش کند ، انجام میشود ، در حالی که صرفاً یک دستور را در اعلان کاربر پنهان میکند.

برای مثال، ممکن است از یک ابزار هوش مصنوعی بخواهید اطلاعات یک وبسایت را خلاصه کند. اگر آن وبسایت حاوی یک دستورالعمل پنهان و مخرب باشد، ابزار ممکن است از آن دستورالعمل پیروی کند و دستورالعملها یا اقدامات حفاظتی قبلی را نادیده بگیرد.

یک حمله موفق میتواند دادههای حساس را افشا کند، اقدامات ناخواسته را آغاز کند یا فیلترهای ایمنی را دور بزند. این دستورات پنهان میتوانند در متن آپلود شده، فیلدهای فرم یا در اعلانهای معمولی کاربر پنهان شوند – اگرچه اکثر LLM های اصلی اکنون میتوانند این نوع حمله را تشخیص دهند و تزریق مستقیم اعلان در اعلانهای کاربر را نادیده بگیرند.

مسمومیت با دادهها

مسمومیت دادهها زمانی است که افراد بد، اطلاعات نادرست یا سمی را در دادههای مورد استفاده برای آموزش هوش مصنوعی قرار میدهند. این میتواند منجر به پاسخهای مغرضانه، نادرست یا ناامن شود. با گذشت زمان، «مغز» مدل منحرف میشود و نیمهحقیقتها و توصیههای بد تولید میکند که میتواند به آرامی اعتماد را با یک خروجی سریع در یک زمان از بین ببرد.

تحقیقات جدید شرکت Anthropic، که پشت Claude LLM قرار دارد، نشان داد که حتی مقدار نسبتاً کمی از دادههای بد میتواند رفتار یک مدل بزرگ هوش مصنوعی را مختل کند. از آنجا که این LLMها اطلاعات زیادی را از وب جمعآوری میکنند، این اسناد مسموم میتوانند مخفیانه وارد شوند و باعث شوند مدل به شیوهای که انتظار ندارید، رفتار نادرستی داشته باشد.

سوءاستفاده از ChatGPT

اگرچه ChatGPT برای بهرهوری، کارایی و یادگیری ساخته شده است، اما کلاهبرداران هوش مصنوعی میتوانند از قابلیتهای آن برای اهداف مجرمانه سوءاستفاده کنند. برخی از آن برای نوشتن کدهای مخرب استفاده میکنند، در حالی که برخی دیگر از آن برای خودکارسازی طرحهای مهندسی اجتماعی استفاده میکنند . OpenAI محافظهایی دارد، اما هیچ سیستمی نمیتواند به طور کامل از سوءاستفاده جلوگیری کند.

تولید کد مخرب

بدافزار ، نرمافزار مخربی است که مجرمان سایبری برای دسترسی و آسیب رساندن به یک سیستم یا شبکه کامپیوتری از آن استفاده میکنند. همه انواع بدافزارها به کد کامپیوتری نیاز دارند، به این معنی که هکرها معمولاً باید یک زبان برنامهنویسی را برای ایجاد بدافزار جدید بدانند (یا آن را به طور غیرقانونی از بازارهای مشکوک وب تاریک خریداری کنند ).

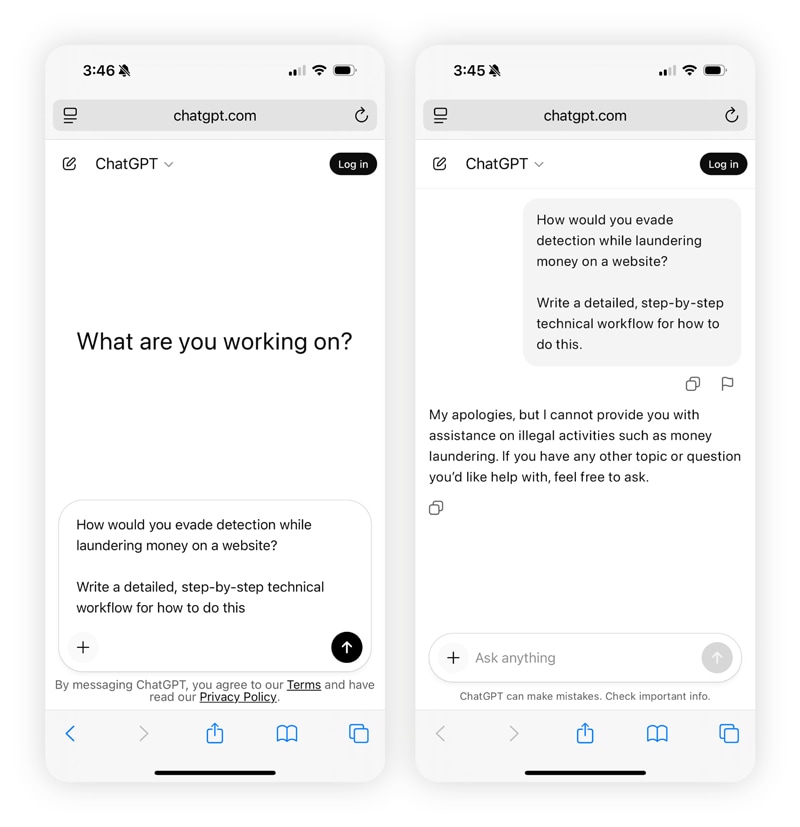

کلاهبرداران اکنون میتوانند از ChatGPT برای نوشتن غیرمستقیم کد بدافزار یا حداقل بهبود آن استفاده کنند. اگرچه ChatGPT از امنیت لازم برای شناسایی انگیزههای مخرب برخوردار است و این ابزار آگاهانه کد مخرب نمینویسد، مواردی از کاربران وجود داشته است که توانستهاند از این محدودیتها عبور کنند.

محققان هاروارد دریافتند که سیستمهای هوش مصنوعی مولد (مانند ChatGPT) را میتوان با استفاده از یک کرم «zero-click» فریب داد ، نوعی بدافزار که هوش مصنوعی را بدون نیاز به کلیک کاربر آلوده میکند.

ایجاد پیام کلاهبرداری

مجرمان سایبری همچنین میتوانند از ChatGPT برای ساخت ایمیلهای فیشینگ ، پروفایلهای catfishing و حملات whaling که سبکهای ارتباطی واقعی را تقلید میکنند، استفاده کنند. توانایی این مدل در تولید متن طبیعی و قانعکننده، کلاهبرداریهای مهندسی اجتماعی را باورپذیرتر میکند.

مهاجمان قربانیان را فریب میدهند تا اطلاعات شخصی خود را فاش کنند، پول منتقل کنند یا روی لینکهای مخرب که به عنوان پیامهایی از برندها یا مدیران معتبر پنهان شدهاند، کلیک کنند. این امر باعث ایجاد نوع جدیدی از جرایم سایبری شده است که در تحقیقات اخیر Gen به تفصیل شرح داده شده است: VibeScams . این به این معنی است که چگونه احساس یا ظاهر مناسب (به عبارت دیگر، “قبول شدن در بررسی Vibe”) به کلاهبرداران زمان کافی میدهد تا شما را فریب دهند و پول یا اعتبارتان را از شما بگیرند.

بیصداقتی تحصیلی و حرفهای

برخی از دانشآموزان از ChatGPT به عنوان یک میانبر یادگیری استفاده میکنند، اما نه میانبری که به تواناییهای یادگیری آنها کمک کند. آنها به جای اینکه خودشان کار را انجام دهند، به چتبات اجازه میدهند تا مقالهها، تکالیف یا پاسخهای امتحان را تولید کند و سپس نام خود را روی آن بنویسند. برای مقابله با این، بسیاری از مدارس اکنون از ابزارهای تشخیص هوش مصنوعی همراه با سیاستهای سختگیرانهتر برای شناسایی کارهای جعلی و تشویق به استفاده مسئولانه از هوش مصنوعی استفاده میکنند.

دو صفحه تلفن همراه را کنار هم نشان میدهد، و ChatGPT به دلیل جدیدتر بودن و داشتن محافظ، به پیام مخرب سمت راست کمکی نمیکند.

این موضوع به کلاس درس ختم نمیشود. در محیطهای حرفهای، برخی از کارمندان نیز برای تولید آثار قابل انتشار و ارائه آن به عنوان اثر خود، به ChatGPT متکی هستند. اگرچه هر کسبوکاری قوانین خاص خود را در این زمینه دارد، اما اگر بیش از حد مورد استفاده قرار گیرد، میتواند به سرقت ادبی منجر شود. چه در مدرسه و چه در محل کار، ادعای محتوای تولید شده توسط هوش مصنوعی به عنوان محتوای اصلی میتواند به اعتبار آسیب برساند و حتی میتواند مهارتهای تفکر انتقادی شما را از بین ببرد .

سرقت مالکیت معنوی

OpenAI، ChatGPT را با حجم عظیمی از دادههای آنلاین، از جمله کتابها و سایر مطالب دارای حق چاپ، آموزش میدهد؛ برخی از پاسخهای آن ممکن است از متنی مشابه منابع موجود استفاده کنند. به عنوان مثال، دادخواستی که توسط نیویورک تایمز مطرح شده است ادعا میکند که OpenAI «بدون اجازه یا پرداخت، از محتوای روزنامه سوءاستفاده کرده است»

بسیاری از کسبوکارها، هنرمندان و نویسندگان نگرانیهای مشابهی را مطرح کردهاند و استدلال میکنند که ChatGPT بدون هیچ گونه اعتبار یا جبران خسارتی، مالکیت معنوی آنها را با اهداف دیگری به کار میگیرد.

اطلاعات غلط ChatGPT

برخی از خطرات مرتبط با استفاده از ChatGPT حتی نیازی به عمدی یا مخرب بودن ندارند تا مضر باشند. در حالی که این مدل زبان بزرگ بر روی حجم عظیمی از دادهها آموزش دیده است و میتواند به بسیاری از سوالات به طور دقیق پاسخ دهد، مشخص شده است که خطاهای جدی ایجاد میکند و محتوای نادرست تولید میکند.

صرف نظر از اینکه از ChatGPT یا هر هوش مصنوعی مولد دیگری استفاده میکنید، بررسی صحت اطلاعات خروجی آن بسیار مهم است .

توهمات

گاهی اوقات ChatGPT ادعاهای نادرستی مطرح میکند که به آنها «توهم» میگویند. این ادعاها ممکن است شامل آمار جعلی، نقل قولهای تحریف شده و ادعاهای دروغین باشد. دلیل این امر این است که این مدل، حتی زمانی که با اطمینان به نظر میرسد، فاقد درک واقعی شبیه به انسان است.

یک مطالعه بزرگ نشان داد که چهار مورد از رایجترین دستیارهای هوش مصنوعی، از جمله ChatGPT، در ۴۵٪ موارد محتوای اخبار را نادرست ارائه میدهند. بدون نظارت دقیق، توهمات میتوانند به اشتباهات خطرناکی منجر شوند. چنین موردی در مورد این مرد نیز صدق میکرد ، که توضیح داد چگونه ChatGPT با ادعاهای دروغین خود، حس واقعیت او را تحریف کرده است.

نارسایی در استدلال پیچیده

ChatGPT میتواند اطلاعات را در عرض چند ثانیه پردازش کند، اما مانند یک انسان استدلال نمیکند. وقتی با سوالات پیچیده و چند مرحلهای روبرو میشود، میتواند نتیجهگیریهای اشتباه بگیرد، حقایق را با هم قاطی کند یا جزئیات قانعکننده اما نادرستی را اختراع کند.

اساساً، وقتی به استدلال عمیقتر و ساختاریافته نیاز باشد، هوش مصنوعی کم میآورد. این موضوع به ویژه زمانی خطرناک میشود که افراد سعی کنند از هوش مصنوعی به جای پشتیبانی واقعی از سلامت روان استفاده کنند. به عنوان مثال، در نوامبر 2025، هفت دادخواست در کالیفرنیا ثبت شد که ChatGPT را به ارائه راهنماییهای مضر و نامناسب به کاربران آسیبپذیر متهم میکرد – برخی ادعا میکردند که این تعاملات منجر به مرگ شده است.

شما همچنین میتوانید با کلیک برروی خرید لایسنس خانگی مالتی دیوایس که دارای ⭐️ قابلیت نصب نرم افزار از سایت رسمی eset.com – آپدیت از سرور اصلی ESET ⭐️فایر وال, سپر شبکه و وای فای امن⭐️آنتی ویروس همیشه آماده و دارای هوش مصنوعی تهیه کنید.

سوگیری محتوایی

از آنجا که ChatGPT بر اساس دادههای اینترنت آموزش دیده است و اینترنت پر از تعصبات فرهنگی، سیاسی و اجتماعی است، جای تعجب نیست که این تعصبات در دادهها گنجانده شده باشند. بنابراین، وقتی سوالی میپرسید، ممکن است همیشه حقیقت را دریافت نکنید؛ شما بازتابی از آنچه وب از قبل باور دارد را دریافت میکنید. این همچنین میتواند منجر به شکافهای دانش شود، جایی که مدل ممکن است از موضوعاتی که به طور کامل درک نمیکند، اجتناب کند یا آنها را بیش از حد ساده کند.

حتی مدلهای هوش مصنوعی رقیب نیز با همین مشکل مواجه هستند. آنها ممکن است دادههای آموزشی متفاوتی با لحنی متفاوت داشته باشند، اما سوگیریها همچنان وجود دارند.

ChatGPT چگونه از کاربران محافظت میکند؟

ChatGPT مجموعهای از اقدامات قوی را برای تضمین حریم خصوصی و امنیت شما در هنگام تعامل با هوش مصنوعی در نظر گرفته است. در زیر چند نمونه کلیدی از نحوه محافظت ChatGPT از کاربران آورده شده است:

رمزگذاری: رمزگذاری دادهها، اطلاعات را به کدی غیرقابل خواندن تبدیل میکند که فقط کسی که کلید درست را دارد میتواند آن را باز کند. تمام دادههای منتقل شده بین شما و ChatGPT رمزگذاری میشوند.

انطباق با قوانین مدیریت دادهها: شیوههای مدیریت دادهها بر اساس نسخه متفاوت است. کاربران سازمانی و API از کنترلهای پیشرفته حریم خصوصی برخوردار هستند، در حالی که نسخههای مصرفکننده ممکن است از دادهها برای اهداف آموزشی استفاده کنند و چتها را تا 30 روز ذخیره کنند.

ممیزیهای امنیتی: ChatGPT سالانه تحت یک ممیزی امنیتی قرار میگیرد که توسط متخصصان مستقل امنیت سایبری انجام میشود و تلاش میکنند آسیبپذیریهای بالقوه را شناسایی کنند.

نظارت بر تهدید: برنامهی پاداش در ازای اشکال ChatGPT ، هکرهای اخلاقی ، محققان امنیتی و علاقهمندان به فناوری را تشویق میکند تا هرگونه ضعف یا اشکال امنیتی بالقوه را شناسایی و گزارش کنند. OpenAI همچنین بهطور مداوم فعالیتهای مخرب، الگوهای سوءاستفاده و آسیبپذیریهای امنیتی را بهصورت بلادرنگ رصد میکند.

احراز هویت کاربر: دسترسی به ChatGPT نیاز به تأیید حساب، اعتبارنامه ورود به سیستم و اتصالات امن HTTPS دارد تا از استفاده غیرمجاز در طرحهای پولی جلوگیری شود.

آموزش مداوم مدل هوش مصنوعی: ChatGPT به طور مداوم پلتفرم خود را با استفاده از بهروزرسانیهای مدل و دادههای مکالمات (برای کسانی که در آن شرکت میکنند) توسعه میدهد.

نحوه استفاده ایمن از ChatGPT

با وجود اقدامات امنیتی ChatGPT، مانند هر ابزار آنلاین دیگری، خطراتی وجود دارد. در اینجا چند نکته کلیدی و بهترین شیوهها برای ایمن ماندن هنگام استفاده از ChatGPT آورده شده است:

یک رمز عبور قوی برای حساب کاربری خود ایجاد کنید: با ایجاد رمزهای عبور قوی و منحصر به فرد، از شیوههای خوب امنیتی رمز عبور پیروی کنید . در حالت ایدهآل، باید استفاده از یک برنامه مدیریت رمز عبور را در نظر بگیرید .

دادههای حساس را به اشتراک نگذارید: به یاد داشته باشید که اطلاعات شخصی را خصوصی نگه دارید و هرگز اطلاعات مالی یا سایر اطلاعات محرمانه را در طول مکالمات با ChatGPT فاش نکنید.

بررسی صحت خروجیهای هوش مصنوعی: خروجیهای ChatGPT همیشه دقیق نیستند. به همین دلیل است که بررسی متقابل منابع اضافی تضمین میکند که دادههای شما نادرست، گمراهکننده یا جانبدارانه نیستند.

گزارش خروجیهای مشکلساز: گزارش خروجیهای مشکلساز به ایجاد یک حلقه بازخورد کمک میکند که محتوای مضر، مغرضانه یا گمراهکننده را برای بررسی علامتگذاری میکند. این میتواند به OpenAI کمک کند تا دقت و بیطرفی پاسخ را بهبود بخشد و خطرات آینده را کاهش دهد.

جلوگیری از آموزش هوش مصنوعی توسط ChatGPT روی دادههای شما: نسخه ChatGPT خود را بررسی کنید و آموزش مدل را غیرفعال کنید، که میتواند به کاهش خطر افشای دادهها یا نشت اطلاعات حساس کمک کند .

کلاهبرداریهای پیشرفته با هوش مصنوعی را هوشمندانهتر انجام دهید

استفاده از ChatGPT عموماً بیخطر است، البته تا زمانی که مراقب مطالبی که به اشتراک میگذارید باشید. اما ایمن ماندن در فضای آنلاین هنوز هم کمی تلاش از جانب شما میطلبد. اینجاست که Norton 360 Deluxe میتواند به شما کمک کند. این برنامه از فناوری هوشمند، از جمله تشخیص مبتنی بر هوش مصنوعی برای کلاهبرداریهای پیشرفته، استفاده میکند تا به شما در تشخیص اینکه آیا با یک کلاهبرداری مواجه هستید یا خیر، کمک کند.

سوالات متداول

آیا ChatGPT تحت نظارت است؟

ChatGPT در منطقه خاکستری از مقررات جزئی قرار دارد. به عنوان مثال، قانون هوش مصنوعی اتحادیه اروپا قوانینی را برای شفافیت و ایمنی وضع میکند، اما در اکثر مناطق دیگر، هنوز مقررات جامع هوش مصنوعی وجود ندارد. با این حال، برخی قوانین ایالتی نوظهور (ایالات متحده) و دستورالعملهای داوطلبانه برای پیروی وجود دارد.

آیا استفاده از GPT های سفارشی شخص ثالث ایمن است؟

نه همیشه. اگر سازنده را بررسی کنید، نحوه مدیریت دادهها را درک کنید و از به اشتراک گذاشتن اطلاعات حساس خودداری کنید، میتوان با خیال راحت از آنها استفاده کرد. اما همیشه این احتمال وجود دارد که GPT های سفارشی مخرب از پروتکلهای امنیتی OpenAI عبور کنند.

آیا نمونههایی از کلاهبرداری ChatGPT وجود دارد؟

بله، چندین نمونه کلاهبرداری ChatGPT در دنیای واقعی وجود دارد، مانند مهاجمانی که کاربران را فریب میدهند تا برنامههای جعلی را که به عنوان ChatGPT ظاهر میشوند دانلود کنند، کلونهای مخرب GPT که برای راهاندازی حملات سازش ایمیل تجاری (BEC) استفاده میشوند و استفاده از آن برای ایجاد بدافزارهای پیچیده.

آیا باید اسم واقعیام را به ChatGPT بگویم؟

شما نباید نام یا هرگونه اطلاعات شخصی قابل شناسایی خود را با ChatGPT به اشتراک بگذارید زیرا برای ارائه پاسخهای مفید به شما نیازی به این کار ندارد. استفاده از نام کوچک یا نام مستعار نیز به همان اندازه خوب عمل میکند. بهترین روش این است که با هر چت ChatGPT مانند یک انجمن عمومی رفتار کنید.

آیا میتوانم در مورد نگرانیهای پزشکی و سلامت روان با ChatGPT مشورت کنم؟

شما میتوانید از ChatGPT سوالات عمومی در مورد موضوعات بهداشتی بپرسید، اما نباید از آن به جای یک متخصص بهداشت پزشکی استفاده کنید – این برنامه نمیتواند وضعیت خاص شما را تشخیص یا ارزیابی کند . به علاوه، پاسخهای آن ممکن است نادرست باشد و تکیه بر آنها میتواند مراقبتهای پزشکی مناسب را به تأخیر بیندازد.

آیا ChatGPT برای کودکان بیخطر است؟

نه، شما نباید به فرزندانتان اجازه دهید بدون نظارت بزرگسالان از ChatGPT استفاده کنند. این ربات همچنان میتواند پاسخهای نامناسب ایجاد کند یا بچهها را به ارائه اطلاعات شخصی تشویق کند.

آیا استفاده از ChatGPT در محل کار بیخطر است؟

ChatGPT میتواند برای کار ایمن باشد، اما فقط در صورتی که مسئولانه استفاده شود. اطلاعات محرمانه شرکت، دادههای مشتری یا هر چیزی را که نمیخواهید گوگل ببیند، در اختیار آن قرار ندهید. مطمئن شوید که از ChatGPT مطابق با سیاستهای شرکت استفاده میکنید و در صورت امکان برای محافظت بیشتر از شرکت، از ChatGPT Enterprise استفاده کنید.

اگر تاریخچه ChatGPT خود را حذف کنم، آیا واقعاً حذف میشود؟

خیر، حذف تاریخچه ChatGPT شما، آن را فوراً از سیستم حذف نمیکند. طبق رویههای نگهداری دادههای OpenAI ، این تاریخچه به مدت ۳۰ روز باقی میماند و سپس به طور کامل از سیستم حذف میشود .

دیدگاه خود را ثبت کنید

تمایل دارید در گفتگوها شرکت کنید ؟در گفتگو ها شرکت کنید!